Le LSCE (CEA-CNRS-UVSQ-UPSaclay) a participé à des exercices de comparaison au meilleur niveau mondial de mesures d’isotopes de bore. L’objectif est de partager des références communes pour les recherches sur l’acidification de l’océan et ses impacts sur les organismes marins calcifiants.

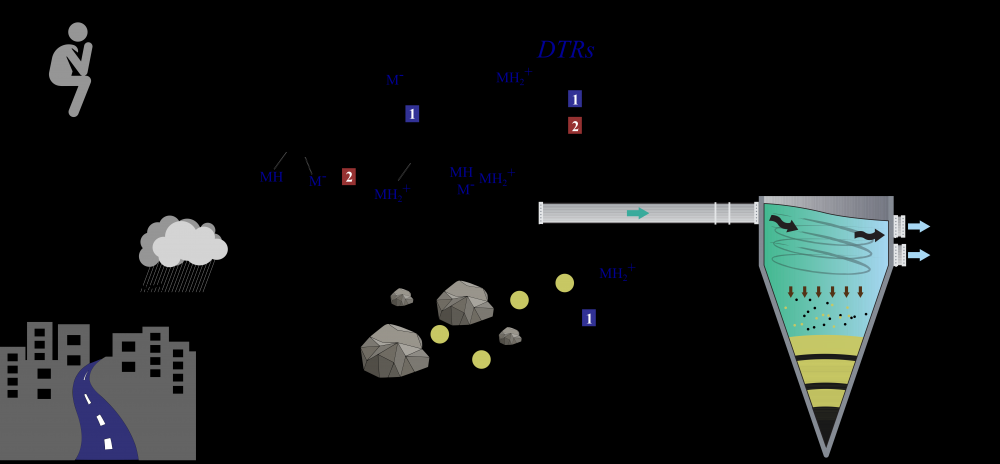

Afin d’étudier l’acidification de l’océan provoquée par l’augmentation des émissions anthropogéniques de CO2, le LSCE a développé des outils géochimiques utilisant la mesure du bore et de ses isotopes (11B, 10B) dans les carbonates d’origine biologique et marine. Ces traceurs servaient initialement à reconstruire l’évolution de l’acidité (pH) et de la chimie des carbonates de l’océan.

Ils caratérisent également la capacité d’organismes comme les coraux à former leur squelette calcaire et donc leur résilience face à la transformation de leur habitat. Ainsi, les chercheurs mesurent-ils la teneur isotopique en bore 11 (rapport 11B/10B) et des teneurs en bore et en calcium (B/Ca) dans l’aragonite constituant le squelette d’une colonie de corail. Ces mesures leur permettent de déterminer les propriétés physico-cimiques du fluide interne de calcification qui régulent la croissance et le développement des coraux.

Pour y parvenir, il est nécessaire de mesurer à quelques 0,1 ‰ près la composition isotopique du bore dans les coraux et l’eau de mer et pour cela, de disposer de carbonates ou de solutions de référence parfaitement caractérisées.

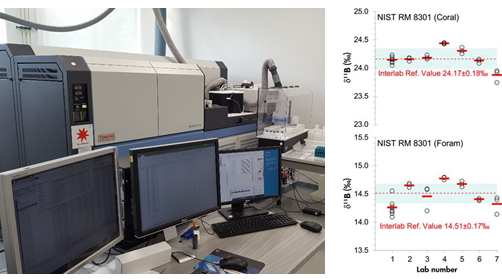

Le LSCE a participé récemment à deux exercices de comparaison inter-laboratoires. Les chercheurs ont déterminé avec une très grande précision les teneurs en isotopes 11B et 10B de deux carbonates standard internationaux (corail et bivalve), régulièrement utilisés dans les laboratoires et ont également caractérisé de nouvelles solutions standard (corail et foraminifère) du National Institute of Standards and Technology, qui seront prochainement disponibles pour la communauté scientifique.

Ces travaux démontrent la qualité des mesures réalisées par les experts du LSCE sur des isotopes du bore dans les archives naturelles par spectrométrie de masse à source Plasma MC-ICPMS Neptune.

Depuis, les standards NIST caractérisés par ces exercices de comparaison inter-lab sont disponibles sur le marché :

https://www-s.nist.gov/srmors/quickSearch.cfm?srm=8301

Références :

Gutjahr M., Bordier L., Douville E., Farmer J., Foster G.L., Hathorne E.C., Hönisch B., Lemarchand D., Louvat P., McCulloch M., Noireaux J., Pallavicini N., Rae J.W., Rodushkin I., Roux P., Stewart J.A., Thil F. and You C.‐F. (2020) Sub‐Permil Interlaboratory Consistency for Solution‐Based Boron Isotope Analyses on Marine Carbonates. Geostandards and Geoanalytical Research. doi: 10.1111/ggr.12364

Stewart J.A., Christopher S.J., Kucklick J.R., Bordier L., Chalk T.B., Dapoigny A., Douville E., Foster G.L., Gray W.R., Greenop R., Gutjahr M., Hemsing F., Henehan M.J., Holdship P., Hsieh Y.‐T., Kolevica A., Lin, Y.‐P. Mawbey E.M., Rae J.W., Robinson L.F., Shuttleworth R., You C.‐F., Zhang S. and Day R.D. (2020) NIST RM 8301 Boron Isotopes in Marine Carbonate (Simulated Coral and Foraminifera Solutions): Inter‐laboratory δ11B and Trace Element Ratio Value Assignment. Geostandards and Geoanalytical Research. doi: 10.1111/ggr.12363

Contact : Éric Douville (LSCE)